摘要

在應用程式商店優化(ASO)中,A/B 測試是提升下載量的重要工具。本篇文章將深入探討如何進行最佳結果的 A/B 測試,幫助您更有效地吸引目標用戶。 歸納要點:

- 數據驅動的個人化:結合使用者行為與機器學習,針對不同族群提供個性化的 A/B 測試。

- 多層次 A/B 測試:不僅測試單一元素,更同時調整標題、副標題、截圖等,以了解各元素間的相互影響。

- AI 輔助分析:利用 AI 技術自動生成有效的測試變體,提高測試效率並精準推薦最佳選項。

ASO 測試:提升應用程式下載量的利器

應用程式行銷人員和開發者經常為如何增加應用程式下載量而感到困惑。在這個背景下,ASO 測試成為了一項重要的工具。作為行銷的基本組成部分,A/B 測試如果能夠有效地運用於應用商店最佳化(App Store Optimization, ASO),將有能力顯著提升轉換率(從使用者互動到應用程式下載)。應用商店最佳化(ASO)中的 A/B 測試是一項關鍵策略,用以提升您的應用程式在各大應用商店中的可見度和轉換率。這一過程涉及比較兩種或多種版本的應用資產,例如截圖、圖示設計和描述,以確定哪個版本表現更佳。其目的是利用實證資料來增強使用者參與度並最佳化應用程式的功能。

在本文中,我們將探討 A/B 測試在 ASO 領域的核心意義,並告訴您如何開始第一次 A/B 測試,展示 Asolytics 平台的一個範例以及如何進行測試。我們還會強調在測試早期階段需要避免的常見陷阱。

傳統的 A/B 測試通常只著重於靜態元素,例如 App 圖示、截圖或文字描述。隨著 AI 技術的不斷進步,新型 A/B 測試方法逐漸浮出水面。例如,可以使用 AI 生成不同版本的 App 預覽影片,並透過 A/B 測試比較它們的點選率和轉換率。這些動態影片可以更加生動地呈現 App 的功能,同時根據使用者興趣和行為進行個性化設定,最終提升使用者參與度及下載率。

而談到 A/B 測試的精準性,我們必須承認,在制定策略之前,需要充分了解不同變數對結果可能造成影響。因此,在執行測試時,不僅要關注靜態元素,也要考慮到動態內容及其背後所帶來的人性化體驗,以此達到最佳效果。

我們在研究許多文章後,彙整重點如下

網路文章觀點與我們總結

- 環保意識逐漸提升,越來越多人開始重視可持續生活方式。

- 許多企業開始實施綠色政策,致力於減少碳足跡。

- 社會運動和倡導者的努力推動了政府在環保法規上的改進。

- 科技創新為解決環境問題提供了新的思路,例如清潔能源與回收技術。

- 個人行為的改變,如減少塑膠使用,也對環境保護產生影響。

- 教育宣導是提高公眾環保意識的重要途徑,特別是在年輕一代中。

如今,隨著全球對環境問題的重視度上升,我們每個人都能夠成為改變的一部分。不僅企業紛紛推出綠色政策,就連我們日常生活中的小習慣也能對地球造成積極影響。在這場與時間賽跑的戰役中,我們不妨從自己做起,比如減少一次性塑膠、選擇公共交通等,以此共同守護我們美好的家園。

觀點延伸比較:| 環保措施 | 企業實施綠色政策 | 社會運動的影響 | 科技創新應用 | 個人行為改變 |

|---|---|---|---|---|

| 減少碳足跡計畫 | 推動可再生能源使用 | 倡導減塑運動 | 發展清潔能源技術 | 提高回收率 |

| 推廣綠色供應鏈管理 | 支持環保法律制定 | 參與植樹活動及海洋清理行動 | 利用人工智慧改善資源配置和能效 | 鼓勵使用可重複使用產品 |

| 建立企業社會責任(CSR) | 提升公眾對環境問題的認識和重視程度 | 促進政府公共政策改革以支持環保目標 | 研發創新的廢物處理技術和回收系統 | 提倡簡約生活方式,減少不必要消費 |

| 提供員工綠色培訓課程 | 舉辦社區環保活動 | 積極參加全球氣候行動日 | 開發智能家居節能設備 | 推廣無包裝商店與共享經濟 |

設定明確的目標,為您的應用程式 ASO AB 測試奠定堅實基礎

在啟動 ASO AB 測試之前,設定清晰且可衡量的目標是非常重要的。這些目標可以包括提高點選率 (CTR) 或增加下載數量等。擁有明確的目標,可以幫助您更好地衡量測試的效果,同時專注於對應用程式成功最為關鍵的指標。接著,確定您計畫測試的應用程式列表中的哪些元素。常見的變數包括應用圖示、標題、截圖、影片預覽和描述。建議一次只測試一個變數,以便準確地將效能變化歸因於特定被測試元素。這種方法確保您的結果清晰且具可行性。

雖然兩大應用商店都提供了測試機會,但 Google 和 Apple 商店的條款與條件卻有所不同。在當今快速發展的市場中,傳統 ASO AB 測試往往針對整體使用者群進行,忽略了使用者群體內部多元性的潛力。隨著人工智慧和資料分析技術的不斷進步,我們現在能夠更精細地細分使用者,例如:

* **使用者行為:** 分析不同使用者在 App Store/Google Play 的行為模式,如首次下載、頻繁使用或高付費率等。

* **人口統計:** 根據年齡、性別、地區及收入等人口統計資料將使用者分類。

* **興趣偏好:** 透過分析使用者所下載的其他應用和瀏覽過的網頁內容來了解其興趣偏好。

透過這些細分,我們可以針對不同型別的使用者進行更具針對性的 ASO AB 測試。例如,針對首次下載的新手使用者,可以採用更吸引眼球的標題與截圖;而對於那些高付費率之客戶則可以強調應用中的付費功能及其優勢。在結合機器學習技術後,可以持續最佳化這些策略,使得每次測試不僅是簡單比較,而是一個自我增強、自我學習的迴圈,不斷提升我們在市場上的競爭力。

Google Play 和 App Store 的 A/B 測試:靈活性與限制

**Google Play:** Google Play 允許同時執行最多 5 個 A/B 測試,每個測試僅限於單一國家/地區。這項靈活性使開發者能夠針對不同市場進行更精準的測試,有效找出最佳應用程式版本。Google Play 還容許在其他專案審核過程中進行 A/B 測試,這意味著開發者可以在提交審核時同步進行測試,從而節省寶貴的時間。所需的截圖格式為 6.5 英寸。**App Store:** 相較之下,App Store 僅允許同時執行 1 個 A/B 測試,在審核過程中也限制了測試的時間和數量。它提供了更廣泛的裝置尺寸選擇,包括 6.5、5.5 和 12.9 英寸(如有 iPad 版本),這對於重視視覺效果及使用體驗的應用程式開發者而言至關重要。在開始測試之前,首先需分析應用程式並記錄資料,以便於後續測試。為方便起見,可以使用 Asolytics 工具,它能準確動態顯示應用程式指標中的微小變化。

**最新趨勢:** 隨著 A/B 測試日益普及,Google Play 和 App Store 均開始積極最佳化其測試功能,例如增加可調整的變數和提供更詳細的資料分析工具等。預期未來 A/B 測試將更加智慧化,並能提供更全面的資料洞察,使開發者能做出更精確的決策。」

您需要在測試之前分析您的應用程式並記錄資料。為了方便起見,您可以使用 Asolytics 工具。它能準確且動態地顯示您應用程式指標的微小變化。

建立有意義的變體,以確保實驗結果可讀取。

一旦選擇了變數,就可以為測試建立不同的變體。確保這些變體彼此之間有顯著差異,以便獲得有意義的見解。例如,如果您正在測試應用圖示,可以建立不同顏色、設計或風格的變體。變體越鮮明,結果的解讀就會越容易。釋出測試

請前往 Google Play Console 中的「商店列表實驗」部分,並決定哪些地理區域將包含在您的 A/B 測試中。Google Play 與 App Store 的不同之處在於,它允許您為每個實驗選擇單一國家,或者進行適用於多個地區的全球性測試,而這些地區缺乏根據評估專案本身所需的本地化視覺或描述。因此,您需要評估是要在全球範圍內實施實驗還是針對特定國家受眾。

建立效能指標以影響評估精度並確定安裝數量:

- 專注於已安裝應用程式或超過初始 24 小時後仍然保留使用者;

- 將部署的實驗模型(可選擇 A/B/C/D、A/B/C 和 A/B 型式,稍後將提供關於不同功能的詳細資訊);

- 將接觸新測試版本與現有版本之使用者比例;

- 新版本和現有版本之間必須具備的重要區別程度,用來決定哪個版本較優;

- 您對評估結果放置的信心程度。

如需更詳細描述,請查閱官方 Google Play 文件。

應用市場產品頁面最佳化:增強標籤與 A/B 測試

請進入應用市場介面中的產品頁面最佳化增強標籤。在定義測試時,明確您將進行的測試類別(例如 A/B 測試、A/B/C 測試或 A/B/B 測試等其他變體),以及測試將在哪些地理區域啟動(最初的選擇涵蓋所有 39 個國家),並提供預估的測試期間。請上傳您的視覺內容。如需更深入的了解,請參考 App Store 官方文件中提供的綜合指南。在執行測試後,根據您預先設定的目標來分析結果。觀察轉換率、點選率 (CTR) 和使用者互動等指標,以判斷哪個版本表現更佳。利用統計分析驗證結果的重要性,確保所觀察到的差異不是隨機產生的。

針對使用者查詢意圖設計 A/B 測試時,可以考慮以下具體步驟:

- **以使用者查詢意圖為導向的測試設計:**

- **針對不同型別的使用者查詢設計多種測試版本:** 例如,針對 ′免費遊戲′ 查詢,可設計一個強調遊戲免費特色的 A 版本,以及另一個強調遊戲趣味性的 B 版本。

- **測試版本與查詢意圖匹配:** 對於搜尋 ′攝影 App′ 的使用者,A 版本可以突出顯示 App 的核心功能,而 B 版本可以展示 App 的使用案例或獎項。

- **運用搜尋字詞分析工具:** 使用 App Store Search Ads 等工具,分析使用者常用的搜尋字詞,並將這些字詞融入測試版本中。

- **A/B 測試的目標與指標:**

- **目標:** 提升 App 搜尋結果排名、增加 App 安裝次數、提高使用者留存率。

- **指標:** 點選率 (CTR)、轉換率 (Conversion Rate)、使用者留存率 (Retention Rate)、App 內購買率 (In-App Purchase Rate)、使用者評分 (Rating) 等。

隨著個性化推薦系統日益精準,我們也需要關注App在這方面如何呈現,以及如何運用 AI 技術最佳化搜尋排名和提升使用者體驗。在頁面的視覺化設計方面,我們要強調視覺元素(如影象、標題、顏色和排版)的重要性,以提高應用程式本身吸引力及可讀性。

舉例而言,以遊戲類應用程式為例:

- **典型查詢意圖:** “免費遊戲”、“多人遊戲”、“熱門遊戲”、“動作遊戲”等。

- **測試設計:** 為不同型別查詢意圖設計多種實驗,例如,一個突出免費特色的 A 版本、一個強調多人特性的 B 版本,以及一個專注於玩法細節的 C 版本。

- **指標分析:** 分析各變體在 CTR、轉換率及使用者留存等方面表現,以找出最符合不同受眾需求之方案。

總之,在進行任何形式的平台最佳化時,有效整合 E-E-A-T 原則——即專業性(Expertise)、權威性(Authoritativeness) 和可信度(Trustworthiness),能夠豐富文章內容深度,使其既準確又具啟發性。

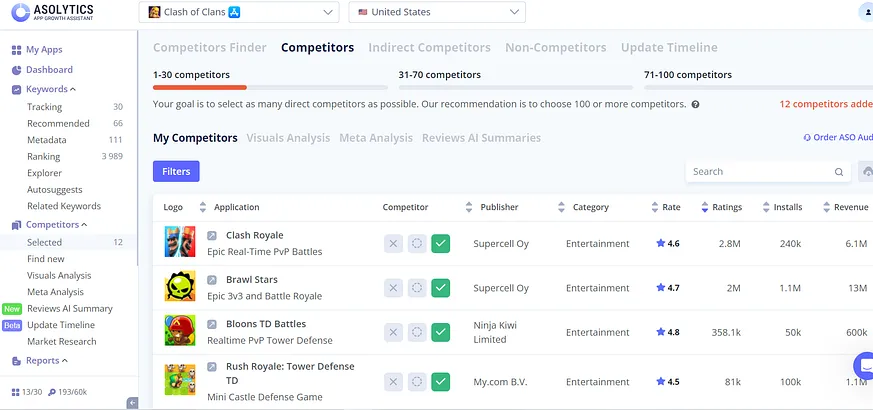

根據您的分析,將贏得的變體實施到您的應用程式列表中。這一步驟是您ASO(應用商店最佳化)努力開始見效的時刻,有潛力增加下載量和使用者互動。監測新資產的表現,以確認正向趨勢持續下去。ASO A/B 測試不僅是分析您應用程式指標變化的過程,同時也涉及競爭對手的變化。因此,您需要在「競爭對手」部分中新增相關競爭者。

Asolytics 平台讓您能夠選擇直接和間接的競爭對手,這大幅提升了資料的資訊含量,並增加了資料處理的變異性。

A/B 測試的時效性和滾動式測試

一個常見的錯誤是過早終止 A/B 測試。在測試尚未完成之前結束,會導致資料不足,從而產生不準確的結論。使用者在工作日和週末的活躍程度有所不同,這可能會顯著扭曲結果。為了避免此類問題,進行 A/B 測試時必須持續足夠的時間:至少 7 天,包括工作日和週末,這應該是您的起始點。如果可行,可將測試時間延長得更長。Asolytics 的專家建議使用完整週數的倍數作為區段。例如,如果您在週一開始測試並決定在週六結束,那就不是正確的決定。最好是在下週一完成測試,以便收集整整一週的相關資料。傳統的 A/B 測試往往重視資料量,但卻忽略了資料收集的時效性。在當今快節奏變化多端使用者行為中,尤其是在科技迅速發展的領域,新產品與技術層出不窮,使用者習慣和偏好也隨之快速調整。因此,我們不僅要關注統計學上的顯著性,更應重視資料收集所需時間視窗,以確保其時效性和代表性。

解決方案之一是引入滾動式 A/B 測試(Rolling A/B Testing)概念。這意味著在測試過程中持續更新對照組,根據最新資料調整測試目標與指標。例如,可以將 A/B 測試週期縮短至 3-5 天,每個週期結束後分析資料並做出相應調整。此方式能靈活應對使用者行為變化,更快獲得有效資料。

在 A/B 測試中深入探討誤差分析也是頂尖專家的重點之一。我們除了關注傳統統計誤差外,也需要考慮其他因素,例如使用者分層,不同使用者群體之間行為模式差異可能導致測試結果偏差;季節性因素,如某些行業和產品容易受到季節影響,因此需考量其對結果的影響;還有技術問題,即測試平台本身可能存在技術缺陷,需要排查以確保結果可靠。

總之,要成功地執行 A/B 測試,不僅需要合適的方法論支援,也需密切留意各種內外部因素帶來的不確定性,以便做出更準確且具啟發性的商業決策。

跨平台 A/B 測試:針對 Google Play 和 Apple App Store 的差異化設計

您可以在我們的文章中了解更多有關「估算曝光報告」工具的資訊。Google Play 和 Apple App Store 的應用介面呈現並不統一,使用者互動也各有不同。因此,若不考量使用者介面和行為的差異,就假設某一平台的測試結果會在另一平台上完全相符,是錯誤的。為了進行準確評估,除非有強而有力的證據表明觀察結果是普遍適用的,否則您應該分別在每個平台上進行測試。因此,Asolytics 平台允許您針對 Google Play Market 和 Apple App Store 分別展示相同應用程式。這項功能正好響應了當前跨平台 A/B 測試日益增長的需求,使開發者能夠根據各自平台特性調整設計與功能,提高使用者體驗及轉換率。

A/B 測試:應用程式轉換率最佳化的利器

持續的行銷活動,例如付費廣告,可能會改變訪客在應用程式商店平台上與您的應用互動的方式。這些使用者對某些元素的反應可能比您的有機受眾更為正面或負面,這可能會影響您檢驗結果的客觀性。A/B 測試是一種有效提升應用轉換率的工具。此方法需要仔細規劃,包括制定明確且具策略性的假設。當執行得當時,分割測試能提供關於使用者行為與偏好的深刻資料。在利用這些資訊後,您可以更有效地精煉和聚焦您的推廣策略。將 A/B 測試與人工智慧 (AI) 驅動的個人化體驗結合,是最新趨勢之一。AI 演演算法能分析海量使用者資料,準確預測特定使用者群體對不同功能或設計元素的反應,以進一步最佳化 A/B 測試。例如,AI 可以幫助識別影響特定使用者群體轉換率的關鍵因素,並針對該群體設計更有效的 A/B 測試方案。

深入來看,結合 A/B 測試與 AI,使得測試策略更加精準、縮短測試週期,同時也能更有效地提升應用程式轉換率。我們鼓勵頂尖專家積極探索利用 AI 驅動的個人化體驗以最佳化 A/B 測試,例如:

- 利用 AI 演演算法建立使用者分群,以便針對不同群體進行更精確的 A/B 測試。

- 使用機器學習模型預測使用者行為,並依此設計出更有效的測試方案。

- 藉由 AI 分析測試結果,即時找出影響轉換率的重要因素並做出相應調整。

透過這些方法,我們不僅可以提高業務效率,也能帶給使用者更加符合其需求和喜好的產品體驗。

參考來源

全部

全部 生活休閒

生活休閒

相關討論