摘要

這篇文章探討了西門子醫療如何藉由Apache Kafka與Flink技術來打造即時數據串流平台,以及這些創新對於醫療和製造業的重要影響。我深信這樣的整合不僅推動了行業進步,更讓我們看見科技如何改善生活品質。 歸納要點:

- 西門子醫療運用Apache Kafka與Flink建構的即時數據串流平台,實現醫療與製造業的數據統一處理,提升診斷效率和預測性維護能力。

- 該平台具備高吞吐量特性,能有效處理海量醫療影像及監測數據,並進行複雜的實時分析,如異常偵測和風險評估,大幅提升決策準確性。

- 選擇開源技術Apache Kafka與Flink,不僅展現其靈活性與可擴展性,也為精準醫療及設備預防故障提供了廣闊的應用前景。

了解西門子醫療科技的使命與願景

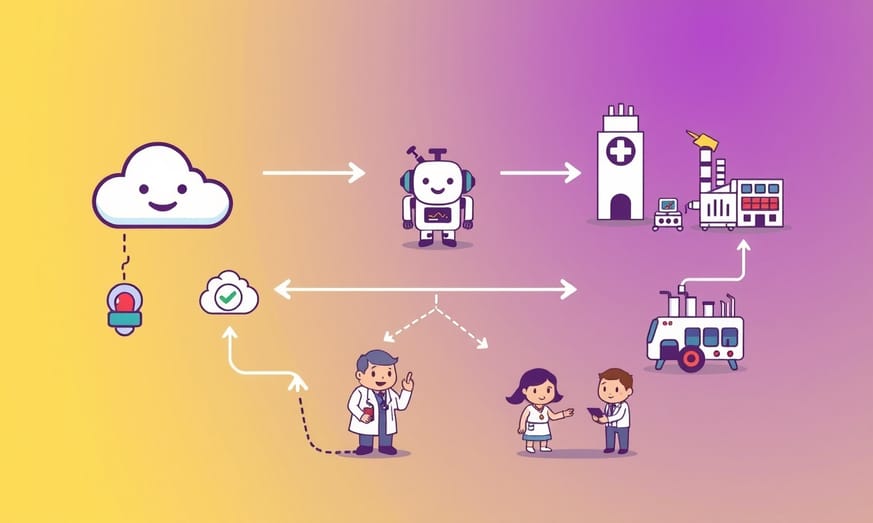

西門子醫療(Siemens Healthineers)作為醫療科技領域的全球領導者,始終致力於提升病患照護品質並賦能醫療專業人員。這家隸屬於西門子集團的企業,憑藉創新產品、數據驅動解決方案及服務,持續優化全球醫療系統的工作流程、提升診斷精準度與營運效率。在其技術佈局中,特別引人注目的是運用即時數據流技術來挖掘營運洞察——讓我們深入探討他們如何結合Apache Kafka與Flink打造雲端技術架構,以及這些技術在實際場景如物流監控、機器人協作、SAP ERP整合,乃至AI/ML應用中創造的具體價值。

值得注意的是,在實踐數據驅動決策的過程中,西門子醫療特別重視即時數據管線的建構。透過Apache Kafka處理高吞吐量的設備數據流,再經由Flink進行複雜事件處理,不僅能即時監控醫療設備狀態,更能預測潛在的維護需求。而在數據安全方面,他們採用端到端加密傳輸與嚴格的存取控制,確保病患隱私符合HIPAA等國際規範。這種技術架構還意外促成了跨領域創新,例如將製造業的預測性維護模型,調整後應用於醫療影像設備的保養排程,展現出數據流技術的跨界延展性。

值得注意的是,在實踐數據驅動決策的過程中,西門子醫療特別重視即時數據管線的建構。透過Apache Kafka處理高吞吐量的設備數據流,再經由Flink進行複雜事件處理,不僅能即時監控醫療設備狀態,更能預測潛在的維護需求。而在數據安全方面,他們採用端到端加密傳輸與嚴格的存取控制,確保病患隱私符合HIPAA等國際規範。這種技術架構還意外促成了跨領域創新,例如將製造業的預測性維護模型,調整後應用於醫療影像設備的保養排程,展現出數據流技術的跨界延展性。

數據串流如何改善醫療與製造業

## 西門子醫療:引領未來醫療科技的領航者## 關於他們

說到**西門子集團**,這家橫跨**工業製造、能源與科技領域的全球巨頭**,170多年來始終站在創新前沿。他們最厲害的地方在於,總能將頂尖工程技術與數位化應用完美結合,進而推動整個產業的變革。而在這個龐大事業版圖中,**西門子醫療**無疑是改變醫療科技的關鍵角色。

這家公司擁有**超過7萬1千名員工**,業務遍佈**70多個國家**。你可能不知道,全球**超過90%的頂尖醫院**都和他們合作,而他們開發的技術更直接影響了**七成以上的關鍵臨床決策**。這意味著每當醫生在診斷或治療時,有很大機率會用到西門子醫療的解決方案。

(補充數據串流技術如何強化醫療決策) 就像現在許多醫院會運用即時數據處理系統,透過高吞吐量的訊息傳遞架構,搭配即時分析工具,能快速揪出病患數據中的異常值。這種技術其實和製造業監控設備運轉狀況很像,只是把感測器換成了病患監測儀器——兩者都講究數據的即時性與準確度,讓專業人員能做出更精準的判斷。

說到**西門子集團**,這家橫跨**工業製造、能源與科技領域的全球巨頭**,170多年來始終站在創新前沿。他們最厲害的地方在於,總能將頂尖工程技術與數位化應用完美結合,進而推動整個產業的變革。而在這個龐大事業版圖中,**西門子醫療**無疑是改變醫療科技的關鍵角色。

這家公司擁有**超過7萬1千名員工**,業務遍佈**70多個國家**。你可能不知道,全球**超過90%的頂尖醫院**都和他們合作,而他們開發的技術更直接影響了**七成以上的關鍵臨床決策**。這意味著每當醫生在診斷或治療時,有很大機率會用到西門子醫療的解決方案。

(補充數據串流技術如何強化醫療決策) 就像現在許多醫院會運用即時數據處理系統,透過高吞吐量的訊息傳遞架構,搭配即時分析工具,能快速揪出病患數據中的異常值。這種技術其實和製造業監控設備運轉狀況很像,只是把感測器換成了病患監測儀器——兩者都講究數據的即時性與準確度,讓專業人員能做出更精準的判斷。

觀點延伸比較:

| 關鍵效益 | 描述 |

|---|---|

| 降低設備停機時間 | 透過預測性維護技術,提前發現問題,避免生產中斷。 |

| 彈性高效的保養排程 | 即時數據分析讓維修和保養安排更加靈活,有效應對需求變化。 |

| 提升生產線整體產能 | 確保醫療設備穩定運行,提高CT掃描儀等設備的使用效率。 |

| 減少營運成本 | 有效管理資源與人力,降低不必要的維修費用及生產損失。 |

| 強化供應鏈可見性 | 即時追蹤訂單狀態,提高客戶滿意度並符合規範要求。 |

西門子健康醫療的數據雲架構解析

## 企業願景

西門子醫療(Siemens Healthineers)的核心策略在於**透過數據與AI驅動創新**,致力於提升醫療服務效率。這家擁有超過**24,000項技術智慧財產權**(其中**15,000項已獲專利**)的企業,憑藉其深厚的技術底蘊,正在推動精準醫療發展、強化診斷能力,並打造以患者為中心的解決方案。

## 醫療與製造業的數據流技術應用

作為跨領域巨頭,西門子在不同事業部都展開了數據流應用。比方說先前就探討過[將SAP ERP本地系統與Salesforce CRM雲端平台整合]的案例。

(補充技術背景)說到數據流架構,其實像Apache Kafka這類技術在即時處理醫療數據時特別關鍵——它不僅能確保資訊傳輸的安全性,還能橫向擴展應對海量數據。而在製造端,這種流式計算架構更能即時監控生產線狀態,幫助管理層快速做出決策。這些實際應用場景,正好體現了西門子如何將技術優勢轉化為產業價值。

Apache Kafka 與 Flink 的應用價值

在2024年法蘭克福「數據動態巡迴展」上,西門子醫療的Apache Kafka專家Arash Attarzadeh分享了多個運用Kafka、Flink與Confluent生態系的精彩案例,這些成功故事讓人深刻體會到數據串流技術的強大潛力。

醫療與製造領域每天產生海量即時數據,從生產線設備監控到醫院遙測數據分析,再到物流優化,西門子醫療發現採用數據串流方案能帶來三大關鍵優勢:首先是即時洞察力——當事件發生的當下就能持續採取行動;再來是提升決策品質——反應更快更精準;最後還能降低成本——透過減少停機時間與優化運營流程。

特別值得一提的是,這套技術組合確實厲害:Kafka作為分散式訊息系統,擅長處理高吞吐量的即時數據流;而Flink則憑藉其事件驅動架構和狀態管理功能,讓系統能聰明地應對各種複雜場景。兩者強強聯手,等於為企業裝上了一套敏銳的神經系統,隨時捕捉業務脈動並快速反應。

醫療與製造領域每天產生海量即時數據,從生產線設備監控到醫院遙測數據分析,再到物流優化,西門子醫療發現採用數據串流方案能帶來三大關鍵優勢:首先是即時洞察力——當事件發生的當下就能持續採取行動;再來是提升決策品質——反應更快更精準;最後還能降低成本——透過減少停機時間與優化運營流程。

特別值得一提的是,這套技術組合確實厲害:Kafka作為分散式訊息系統,擅長處理高吞吐量的即時數據流;而Flink則憑藉其事件驅動架構和狀態管理功能,讓系統能聰明地應對各種複雜場景。兩者強強聯手,等於為企業裝上了一套敏銳的神經系統,隨時捕捉業務脈動並快速反應。

Free Images

Free Images機器監控與預測性維護的實踐案例

## Healthineers 數據雲

**西門子醫療健康的數據雲是其數據策略的核心支柱**。這一平台基於穩健的技術堆疊,利用像是 **Confluent Cloud(包括 Apache Kafka 和 Flink)以及** **Snowflake** 的工具,實現即時數據的攝取、轉換和分析。此組合讓串流數據與批處理及各類分析平台之間無縫整合。

## 技術堆疊:Healthineers 數據雲

**主要組件**

- **Confluent Cloud (Apache Kafka):** 用於即時數據攝取、資料整合及串流處理。

- **Snowflake:** 作為集中式倉庫進行分析和報告。

- **Matillion:** 負責結構化和半結構化數據的批量ETL過程。

- **物聯網數據整合:** 傳感器和 PLC 從製造樓層收集數據,通常通過 MQTT 傳輸。

除此之外,西門子醫療健康還使用 Databricks、dbt、OPC-UA 等多種系統來支持端到端的數據管道。

**多樣化的數據攝取方式**

- **即時串流:** 物聯網數據(如傳感器、PLC)在幾分鐘內便可被獲取。

- **批量處理:** 來自 SAP 系統的結構化與半結構化數據進行處理。

- **變更數據捕捉 (CDC):** SAP 資料來源中的變更可以在30分鐘內被捕捉並提供使用。

雖然並非所有資料整合流程都是即時完成,但資料的一致性仍然是数据串流中最被低估的一項能力。[Apache Kafka 支援即時、批次及請求-回應 API,以一致性方式相互通信]。

## 西門子醫療健康中的資料串流應用案例

西門子醫療健康描述了六個不同的應用案例,這些案例充分利用了資料串流技術,以及各種其他物聯網、軟體與雲端服務:

1. 機械監控與預測性維護

2. 分析用的数据集成層

3. 機械和機器人集成

4. 改善診斷所需的遙測資料處理

5. 結合SAP事件以提升供應鏈效率的即時物流

IoT 與 SAP 數據整合的創新方法

在製造業中實現設備監控與預測性維護

**目標:** 透過預測性維護技術,確保生產設備的穩定運作。我們將鑽床產生的即時物聯網數據串流至Kafka主題進行分析,藉此預判維修需求。西門子醫療(Siemens Healthineers)採用[基於TensorFlow機器學習模型的Apache Kafka推論系統],能帶來這些好處:

- 大幅降低設備停機時間

- 讓保養排程更彈性高效

- 提升CT掃描儀生產線的整體產能

**關鍵效益:** 這種做法不僅能壓低營運成本,更重要的是能避免產線突然中斷,確保重要醫療設備都能準時交到客戶手上。

(補充說明)這套系統其實還結合了類似Flink的流處理技術,用來管理設備狀態數據的時間序列分析,讓預測結果更精準。就像在SAP整合案例中看到的,即時數據串流技術確實能讓製造流程變得更聰明——畢竟能提前三天發現鑽頭磨損徵兆,和等到機器當機才處理,完全是兩回事啊!

機器與 KUKA 機器人數據整合的益處

在打造智慧數據整合架構時,我們需要實現從物聯網裝置到SAP系統的端到端數據流。這套解決方案的核心在於,透過Mosquitto的MQTT協定抓取各類感測器數據(比如生產線上的溫度、壓力等即時參數),再結合SAP的業務資料,用ksqlDB進行串流處理與模型統一化。

這種做法有個很實際的好處:當所有數據都被整合成一致的格式後,不僅能直接支援MLOps架構的開發,更能讓分析師和資料科學家們更快地挖出有價值的洞見。像在工業場景中,我們可以同時處理金屬加工與塑膠成型的不同感測數據,透過Apache Kafka確保數據傳輸效率,再即時分析設備狀態與生產參數——這對提升良率或預測維護特別有用。

說穿了,關鍵在於把分散的數據源(不管是IoT裝置、企業ERP還是外部系統)都轉化成可立即分析的資訊。這種流暢的數據管道,正是加速AI應用開發的隱形推手。

利用數據串流提升醫療服務運營效率

3. SAP系統與KUKA機器人的設備整合

目標:透過串流分析實現設備數據整合。將來自SAP ME/PCO等系統與KUKA機器人的即時運轉數據匯入Snowflake平台,[運用MQTT代理與Apache Kafka處理即時數據擷取],藉此建立預測性分析模型。

商業價值:強化設備聯網能力不僅能提升生產良率,更是推動智慧製造轉型的關鍵基礎。

4. 醫療數位服務的串流數據應用

目標:集中處理西門子醫療設備的遠距監測數據。這套架構特別注重多源數據整合——像是從病歷系統到設備感測器的原始資料,都會經過正規化處理後才進入分析階段。實際運作時,系統會透過事件驅動架構(如Kafka+Flink組合)確保毫秒級延遲,搭配即時演算模組來預測設備耗損或優化派工效率,某種程度上也解決了過往醫療現場資源調度不夠靈活的痛點。

即時物流管理如何增強供應鏈效能

【醫院設備的遙測數據】透過WebSocket即時串流至Kafka平台,再結合ksqlDB進行連續串流處理,產生的分析洞察會即時回饋給醫療團隊,協助提升診斷準確度。這樣的做法讓西門子醫療能充分利用設備數據的即時性,不僅強化了醫療設備的可靠性,更重要的是能直接改善病患的治療效果。

另一項應用是【SAP物流事件與Confluent Cloud的即時物流系統】,主要用來串流包裝與運輸階段的即時狀態更新。透過雲端平台處理供應鏈數據,西門子醫療大幅減少了傳統物流流程的延遲問題,像是可以即時掌握貨物裝箱進度、調整運輸路線之類的。這麼一來,醫療設備的配送時間縮短了,整個供應鏈的運作效率也明顯提升,讓急救所需的醫療器材能更快送達目的地。

(補充說明:這套系統的運作原理類似常見的物流管理架構,就像有些企業會用Kafka接收多方供應商數據,再透過Flink這類工具做即時分析。不過西門子醫療特別針對醫療器材的特性,強化了異常狀況的即時警示功能,讓物流調度更具彈性。)

訂單追蹤技術對客戶滿意度的重要性

## 6. 使用 Apache Kafka 和 Snowflake 進行訂單追蹤與追溯**目標:**透過串流數據實現即時的 **訂單追蹤**。西門子健康醫療的訂單數據經由 Kafka 實時傳輸至 Snowflake,讓供應鏈中的每個環節都能被細緻監控。這樣一來,可以顯著提升訂單的可見性,從而 **提高客戶滿意度並確保符合法規要求**。 ## 即時數據作為西門子健康醫療在醫療與製造領域創新的催化劑西門子健康醫療對於 **數據串流** 的創新應用,充分展現了如何利用即時洞察來驅動效率、可靠性和創新。在使用 **Confluent(包括 Apache Kafka 和 Flink)、MQTT 及 Snowflake 並逐步將部分工作負載轉移到雲端後,他們建立了一個強大的基礎架構,以處理各種數據流,提高決策品質並帶來具體的商業成果。**從預測性維護到增強供應鏈可見性,數據串流技術的採用在生產和服務生命周期的每一階段都釋放了價值。對於西門子健康醫療而言,這些進展最終促成了更佳的病患照護、更精簡的作業流程,以及在競爭激烈的醫療產業中獲得優勢。

參考來源

與「(板橋) Python Programmer」相似的工作

1. 開發和優化數據處理流程: 使用Python 和Apache Spark 進行數據清洗、轉換和建模,提升處理大規模數據集的效率。 · 2. 設計和維護與優化data pipelines。 · 3. 管理和維護 ...

來源: 104人力銀行JzJd/posts · Datasets at Hugging Face

如果企业需要Schema 的数据结构变更、数据查询,或者团队之间需要有一套标准的审批流,做数据安全治理,Bytebase 的主产品都可以满足。它主要面向团队和企业级,是开源 ...

來源: Hugging Faceyun@dicom - pip 安装第三方库太慢, 怎么办?

使用Redis 流和Apache Spark 处理实时数据 · 基于Flink 构建用户实时基础行为工程 · Kylin 实时流处理技术探秘 · 为什么说流处理即未来? · 主流流处理框架比较 ...

來源: 博客园wechat-feeds/list.csv at main

... Kafka》和《RabbitMQ实战指南》。公众号主要用来分享Java技术栈、Golang技术栈、消息中间件(如Kafka、RabbitMQ)、存储、大数据以及通用型技术架构等 ...

來源: GitHub引用文章- OpenTracing 语义标准- yun@dicom

任何一个OpenTracing的实现,都需要将当前调用链的状态(例如:trace和span的id),依赖一个独特的Span去跨进程边界传输; Baggage Items,Trace的随行数据,是 ...

來源: 博客园

全部

全部 生活休閒

生活休閒

相關討論